ProxmoxでCeph(分散ストレージ)を構築しよう! その2

ここでは、Proxmox 8でCephを導入する手順を掲載しています。

Proxmoxのインストール、初期設定、クラスタの構築、Cephのインストールを済ませている必要があります。

[広告]

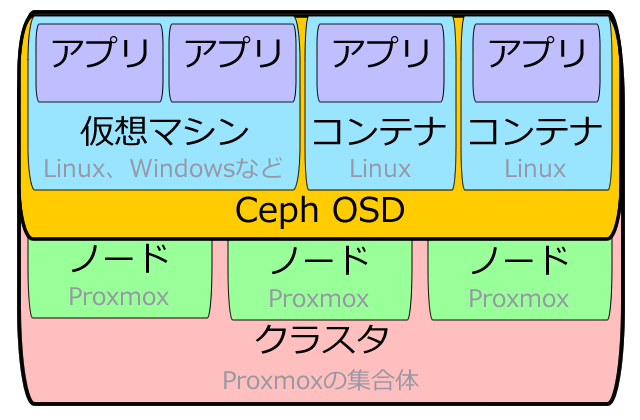

Ceph OSDとは…?

Ceph上で動くストレージ(Object Storage Device)です。複数のノードにまたがる仮想的なストレージを作成・管理します。

保存するデータに応じて、使用する仕組みが異なるようです。

- ・CephFS…isoイメージやコンテナテンプレートなど、 主に変更のされないデータを保存する

- ・RBD…仮想マシンやコンテナなど、主に変更のされるデータを保存する

順を追って構築していきましょう。

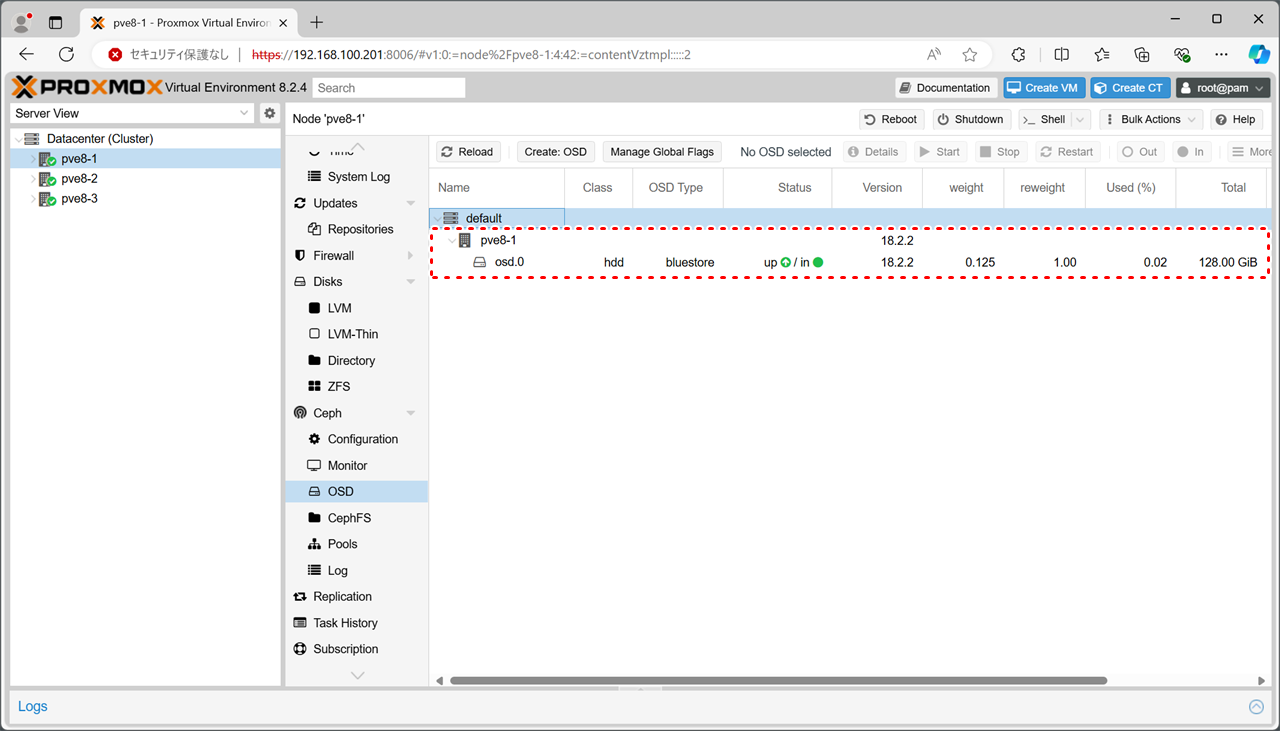

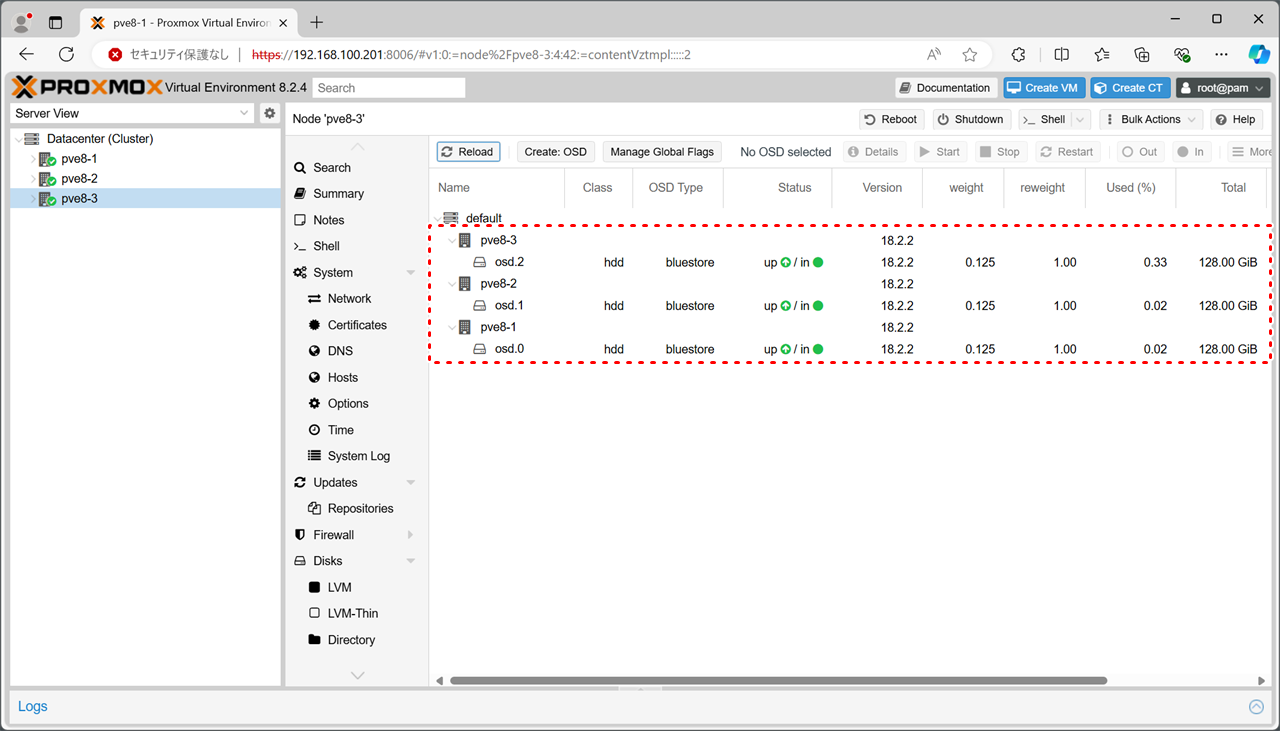

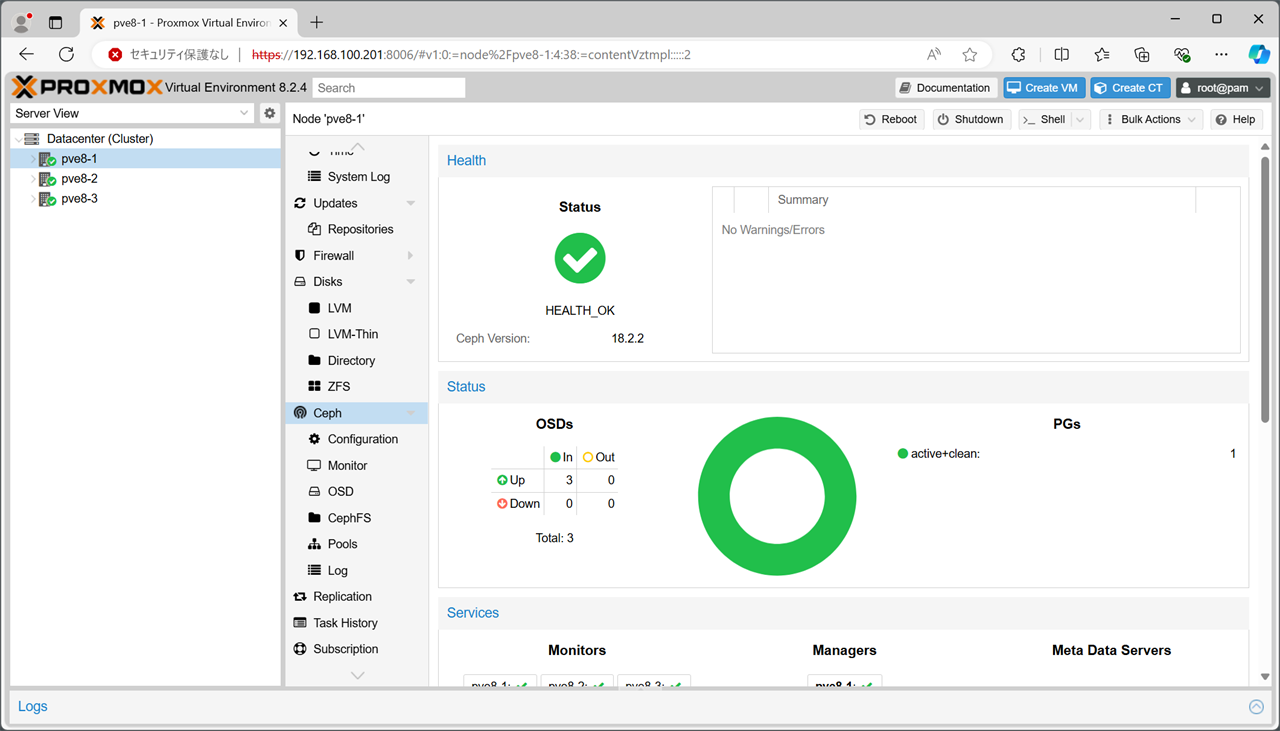

Ceph OSDの作成

まずは1台目(pve8-1)でCeph OSDを作成しましょう。

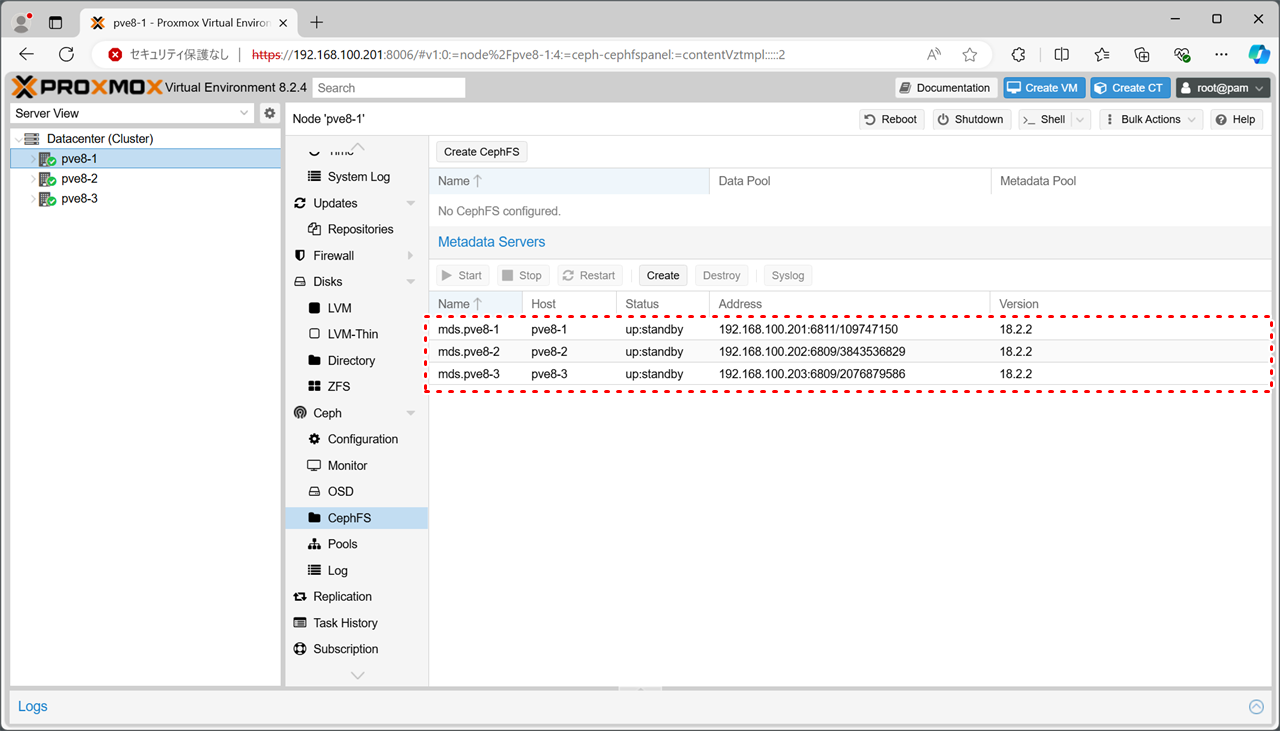

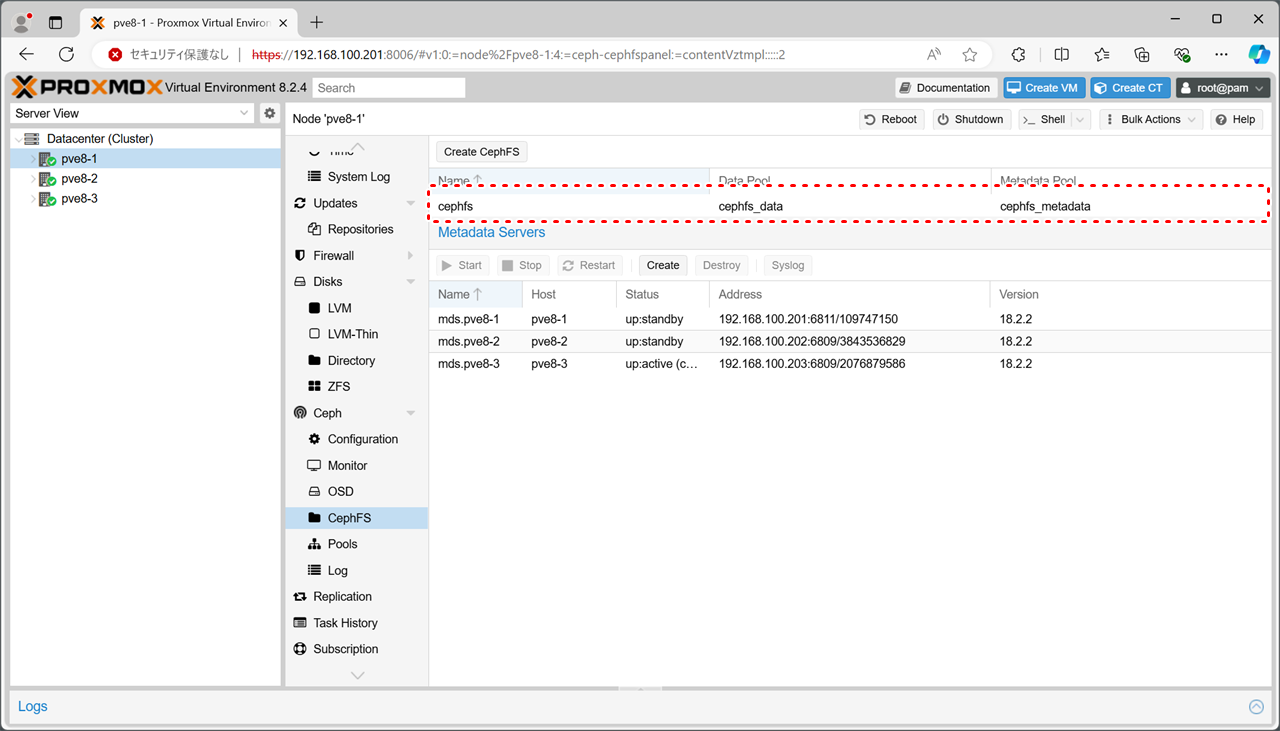

Metadata Serverの登録

Ceph OSD上に保存されるデータを管理する「Metadata Server」を登録していきましょう。

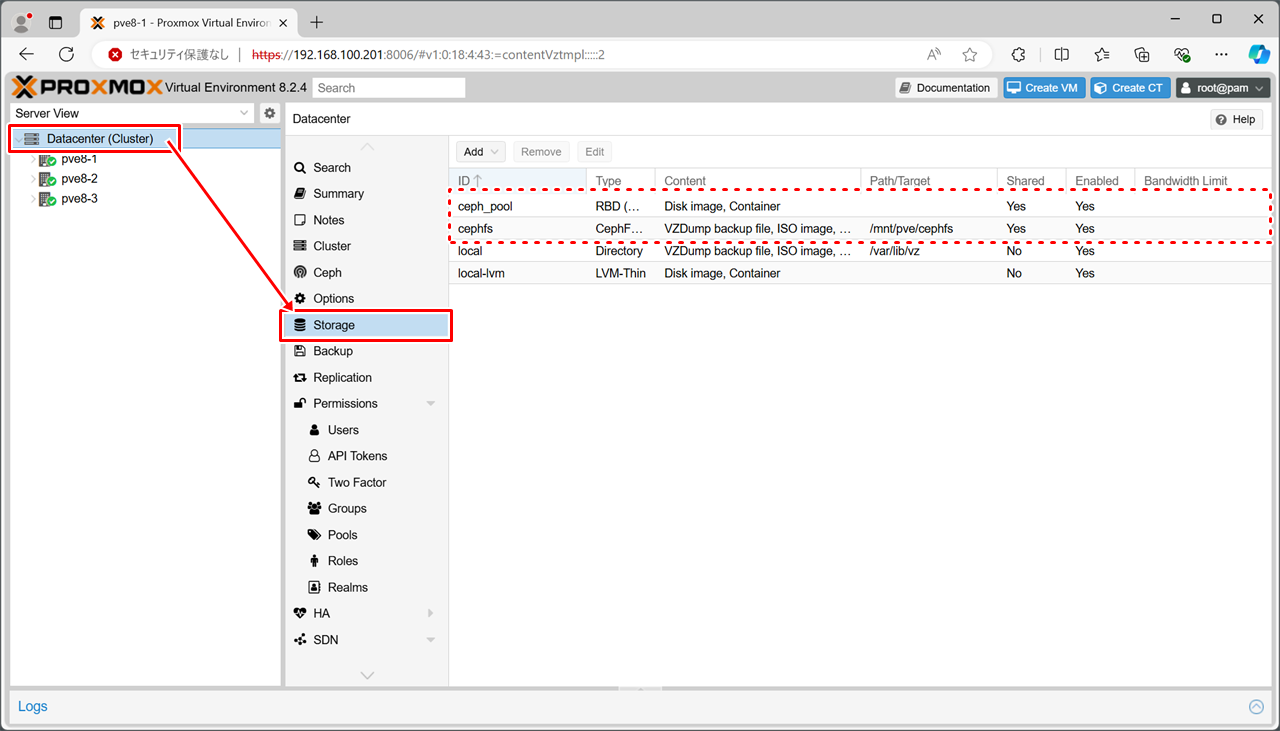

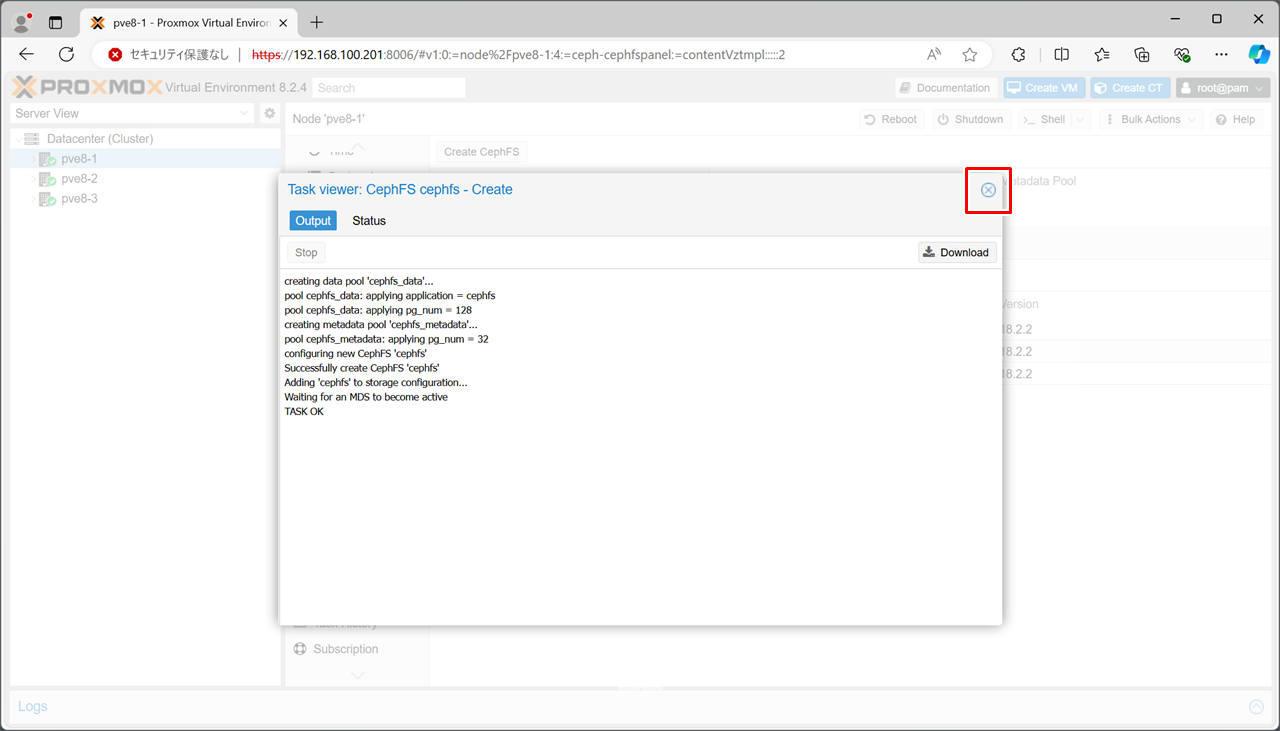

CephFSの登録

isoイメージやコンテナテンプレートなどを保存する「CephFS(Ceph File System)」を作成します。

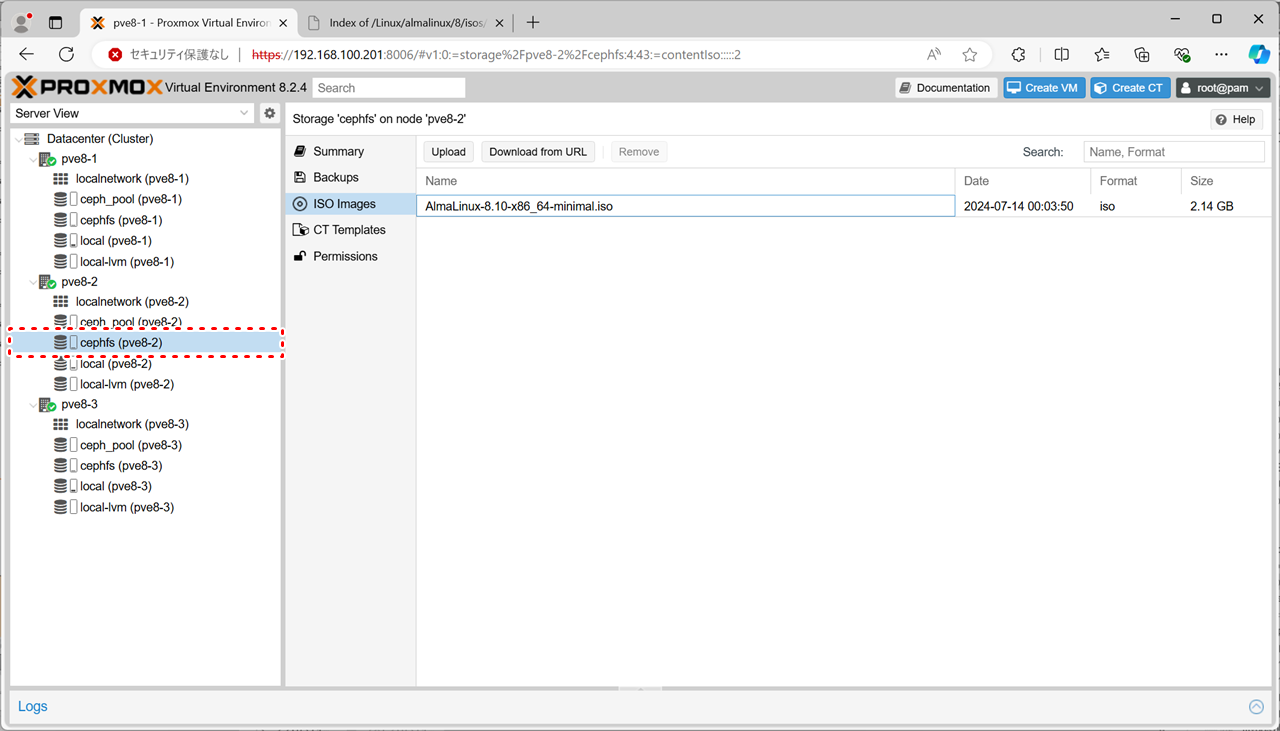

CephFSの動作確認

試しに、CephFS上にisoイメージをダウンロードしたときの動きを見てみましょう。

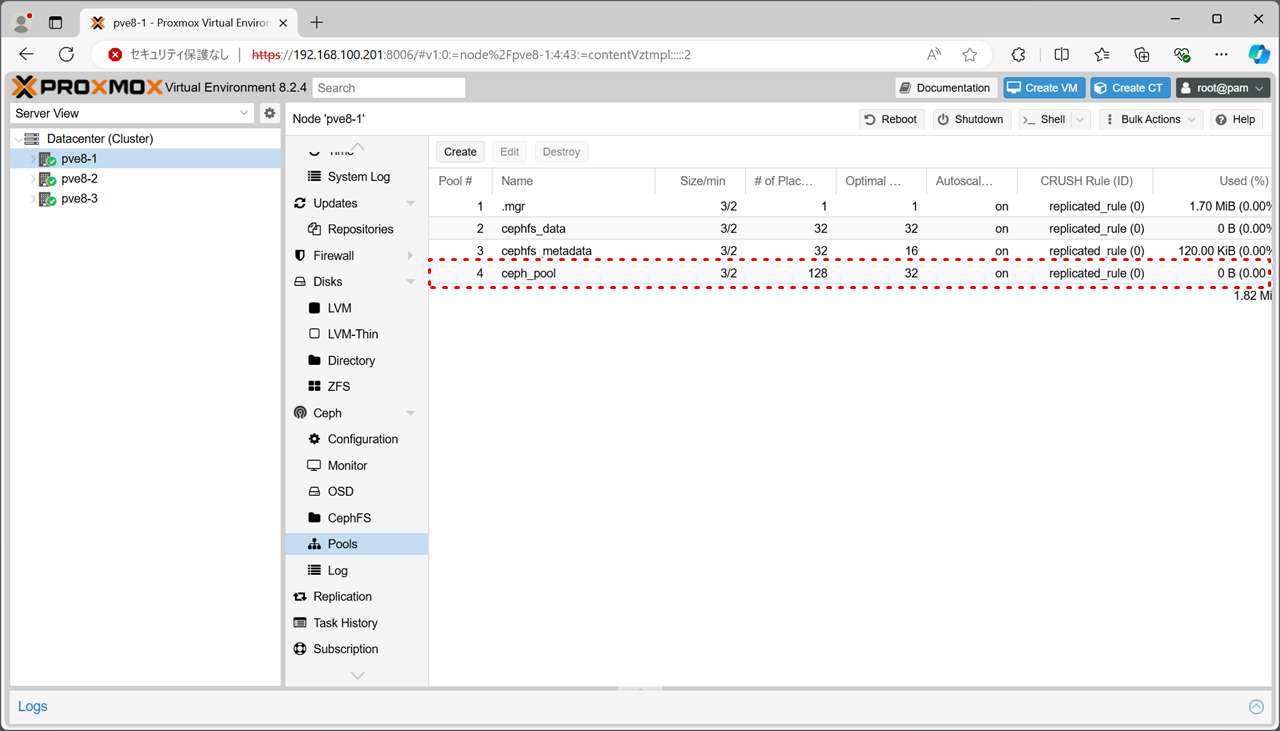

RDBの作成

続いて、仮想マシンやコンテナなどを保存する「RBD(Rados Block Device)」を作成します。

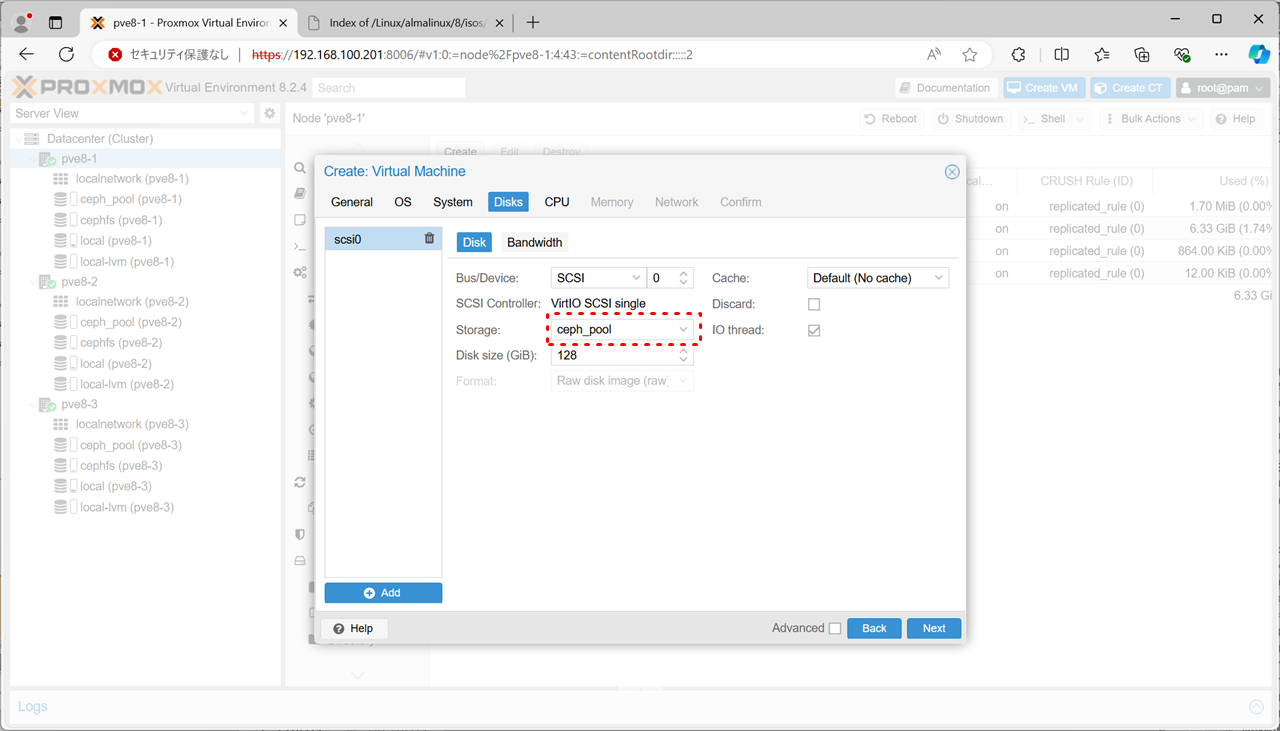

ライブマイグレーション

ceph_pool上に保存された仮想マシンやコンテナのデータは、各ノードにリアルタイムで複製されます。

そのため、仮想マシン/コンテナをノード間で移動するマイグレーションの際に、完全に無停止とはいかないまでも、停止時間を短くすることが可能です。一般的に「ライブマイグレーション」と呼ばれています。

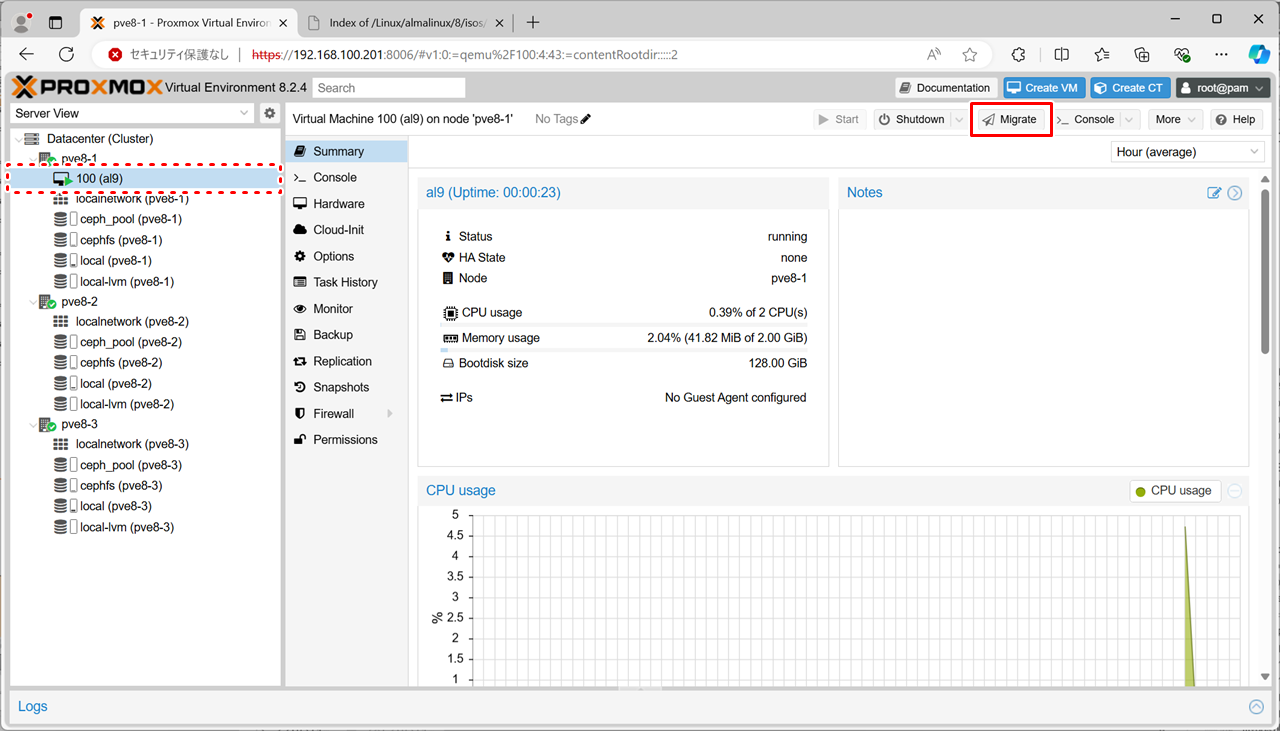

今回は、試しにノード1(pve8-1)で動作している仮想マシンをノード2(pve8-2)に移動してみます。

|

仮想マシンやコンテナの作成時に、保存先を「ceph_pool」としておきます。 |

|

移動したい仮想マシンを選択し、[Migrate] をクリックします。 |

|

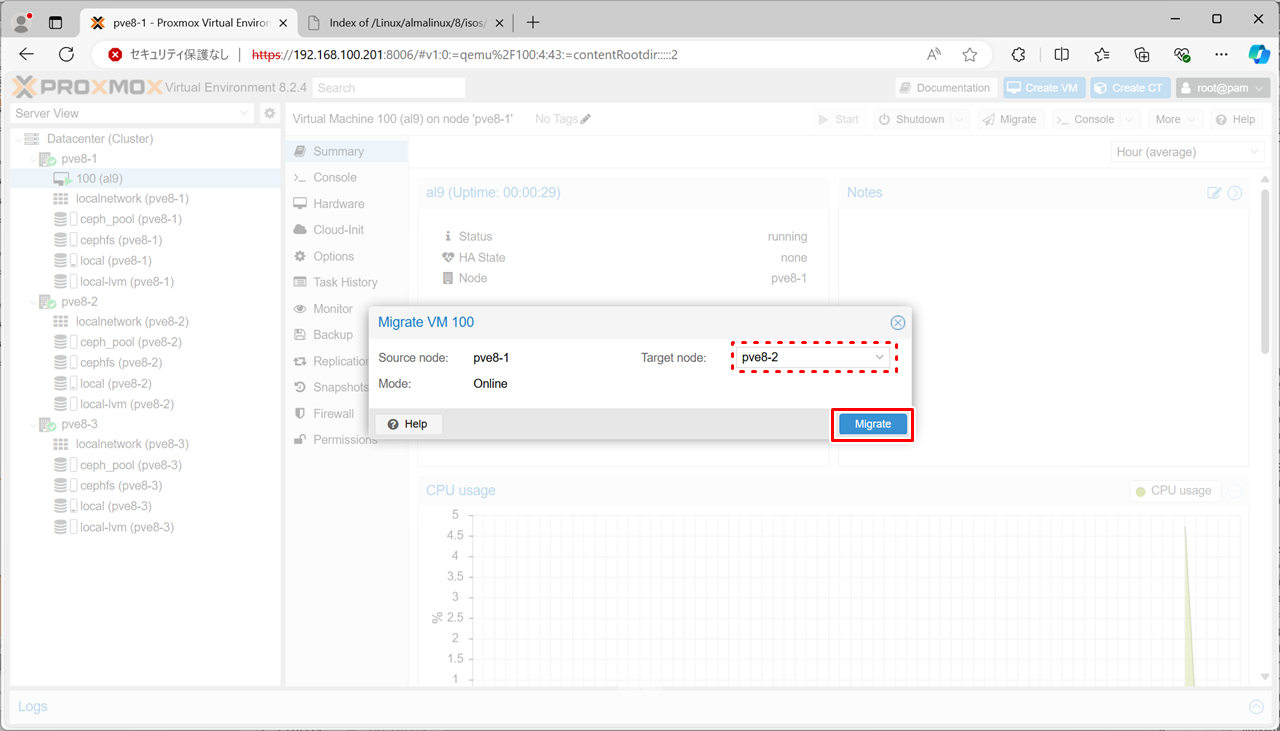

移動先のノードを選択します。 今回はノード2(pve8-2)を選択しました。 |

|

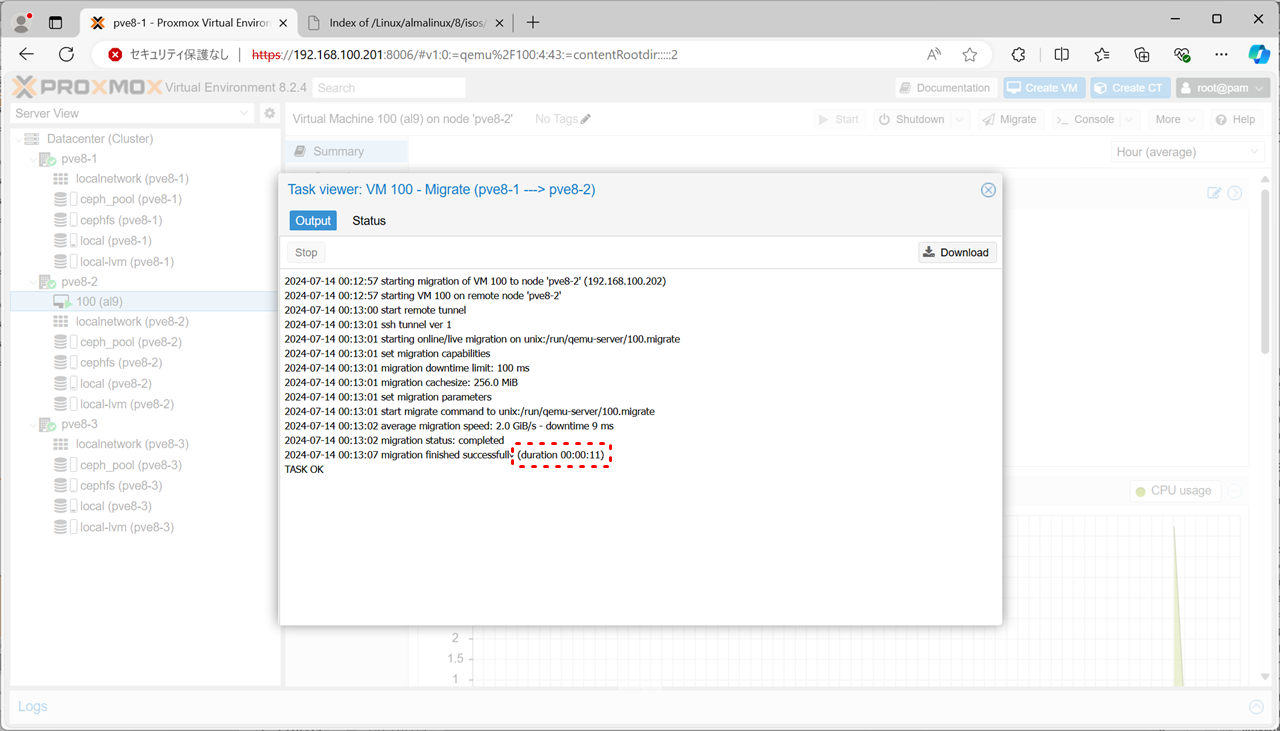

今回は約11秒で移動できたようです。 マイグレーションが完了したら、タスク画面を閉じましょう。 |

このように、短い停止時間でマイグレーションできるようになりました。

ちなみに、ライブマイグレーションはCephを使わなくても可能です。要するに仮想マシンのデータが各ノードから読み出せる共通の場所に置いてあれば良いわけなので、3台もノードが用意できない!という場合はネットワーク上のストレージをiSCSIやNFSなどでマウントして代用することも可能です。

とはいえ、NFSサーバがダウンすると接続している仮想マシン全台がダメになるので、耐障害性という意味ではCephの方に軍配が上がりますね。

参考にしたサイト様

エンジニアブログ - ProxmoxにCEPH突っ込もうぜの巻・その2・OSDセットアップ編

エンジニアブログ - ProxmoxにCEPH突っ込もうぜの巻・その3・ストレージセットアップ編

Qiita - Proxmox VE上でCeph/CephFS環境を作ってみる。

Qiita - 【2024年04月版】Proxmox で Ceph/CephFS構築【初心者向け】

Qiita - 【2024年04月版】Proxmoxのストレージタイプ【iSCSI, LVM, NFS, Ceph, GlusterFS】

Proxmox VE Documentation Index - Deploy Hyper-Converged Ceph Cluster

今回新しく登場したコマンド

[広告]

トップページ

Proxmox 8

◎仮想マシン(VM)の管理

◎コンテナ(CT)の管理

○インストール準備

○基本操作

○導入

○セキュリティ対策

○Dynamic DNS

○NTPサーバ

○クラスタ/Ceph

○その他

![[OSD] - [Create: OSD]をクリック](/images/pve8/ceph_201.png)

![ディスクを選択し、[Create]をクリック](/images/pve8/ceph_202.png)

![[CephFS] - [Create]をクリック](/images/pve8/ceph_301.png)

![ノードを選択し、[Create]をクリック](/images/pve8/ceph_302.png)

![[CephFS] - [Create CephFS]をクリック](/images/pve8/ceph_304.png)

![[Create]をクリック](/images/pve8/ceph_305.png)

![[Pools] - [Create]をクリック](/images/pve8/ceph_501.png)

![任意の名前を入力し、[Create] をクリック](/images/pve8/ceph_502.png)

![[Pools] - [Create]をクリック](/images/pve8/ceph_401.png)

![任意の名前を入力し、[Create] をクリック](/images/pve8/ceph_402.png)